deeplearning

deep learning

课程大纲

1 | 第一章 人工智能概述 9学时 沈华伟 |

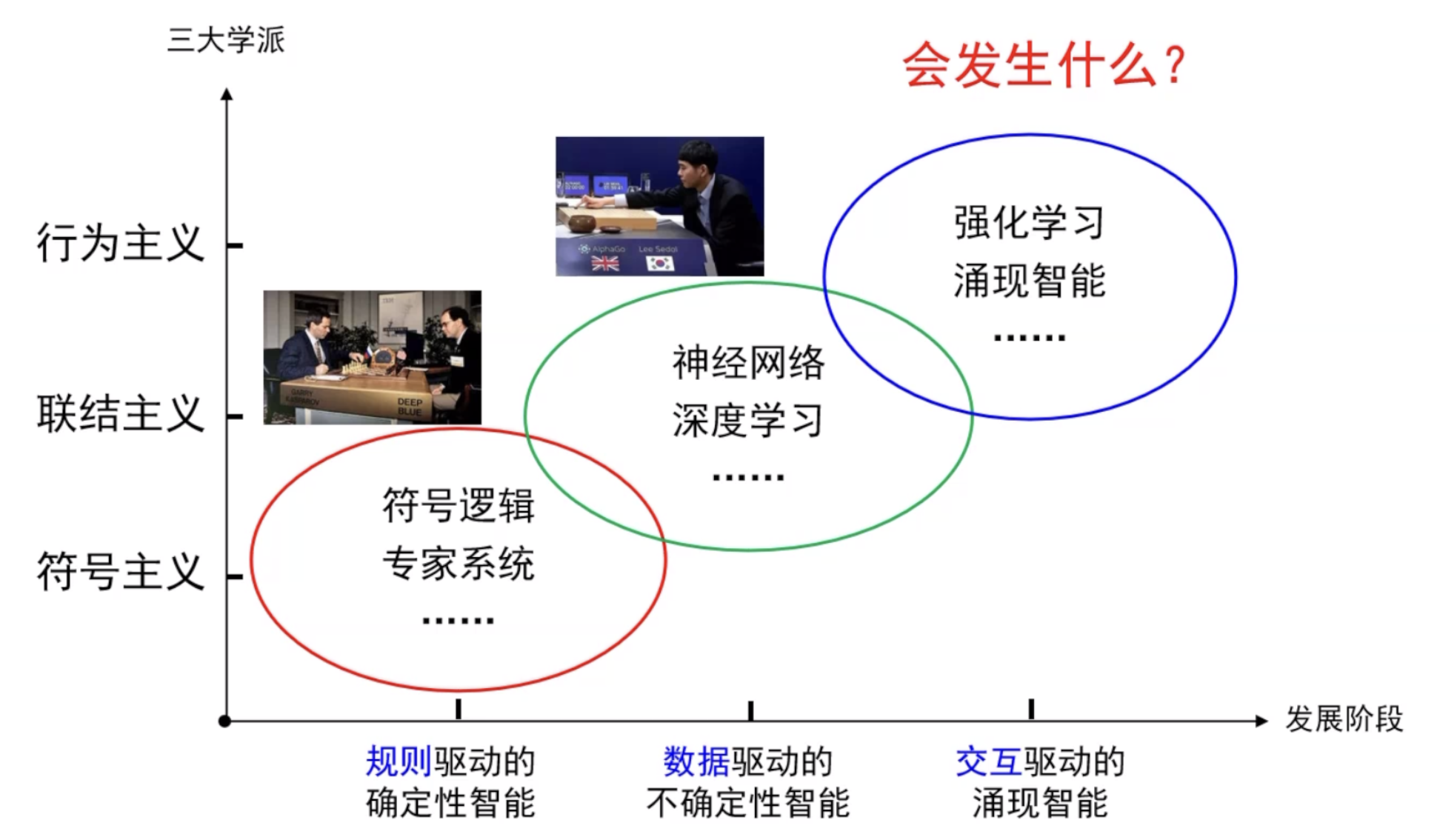

人工智能概述

人工智能发展历程

人工智能基础

搜索问题

搜索问题的元素包括:

- 状态空间

- 初始状态和目标测试

- 后继函数

目标就是得到后继函数(从初始状态到目标状态的每一步行动)

考虑搜索算法的两个出发点:

- 完备性

- 一致性

路径搜索

无信息搜索

无信息搜索指的是除了问题定义中提供的状态信息外没有其他附加信息,有信息搜索知道一个非目标状态是否比其他状态更有希望接近目标

搜索:

- 扩展出潜在的行动

- 维护所考虑的行动的边缘节点

- 试图扩展尽可能少的树节点

重要的点:

- 边缘节点

- 扩展新的结点

- 探索的策略

考虑的主要问题是选取哪些边缘节点来进行探索

搜索算法的特性:

- 完备性(当有解时保证能找到一个解)

- 最优性(保证能找到最优解)

- 时间复杂度

- 空间复杂度

状态空间图

树搜索

不同搜索算法的区别在于对于边缘的处理策略

DFS

BFS

迭代深入搜索

- 迭代深度的DFS,结合了DFS和BFS的优点

- 对DFS进行深度限制,搜索完限制深度后必须开始新的搜索路径

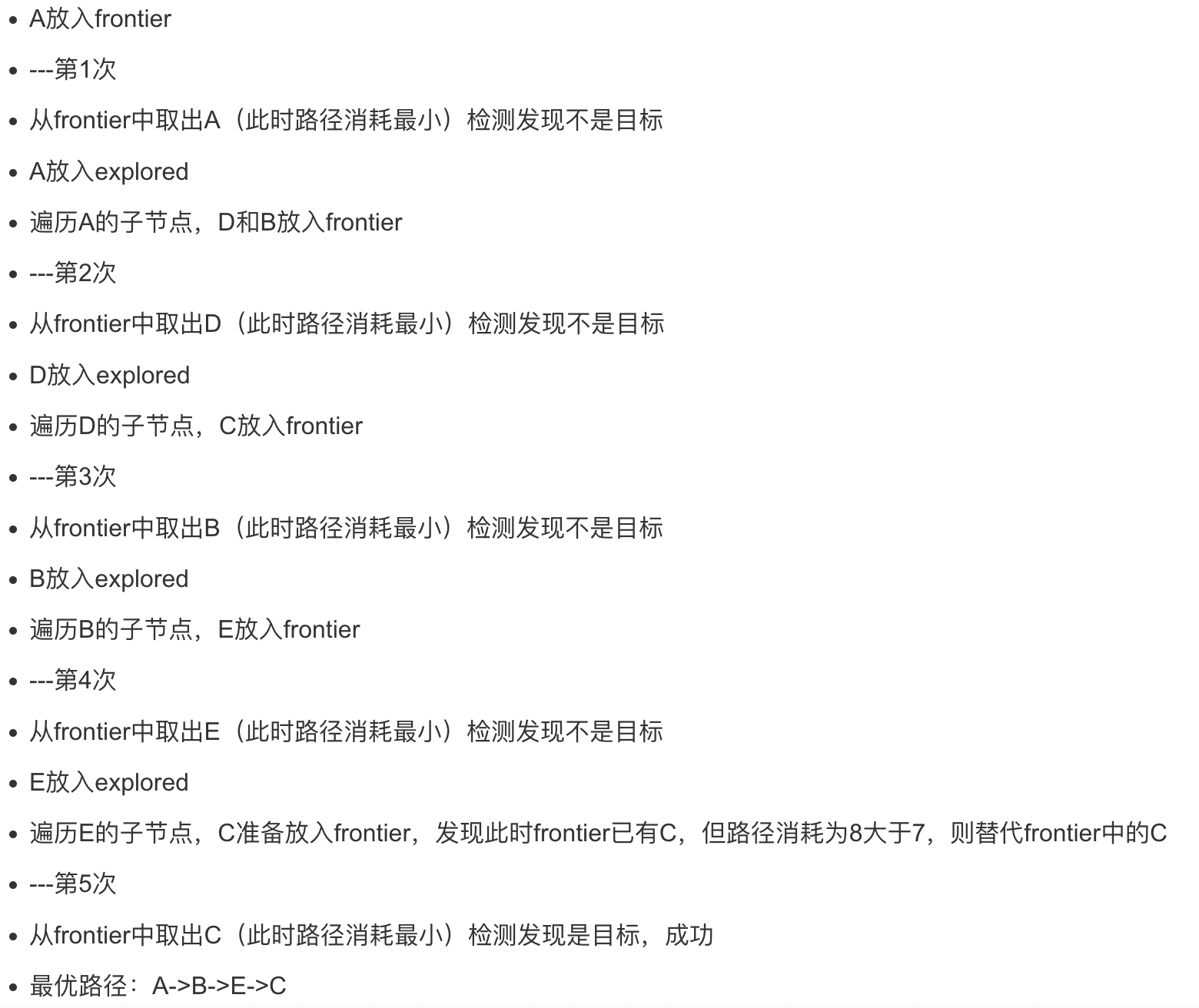

代价一致搜索

- 在BFS基础上进行扩展

- 基本原理:一致代价搜索总是扩展路径消耗最小的节点N。N点的路径消耗等于前一节点N-1的路径消耗加上N-1到N节点的路径消耗

- UCS是完备的(不存在零代价),是最优的

Example:

Solution:

图搜索

- A*图搜索

启发式搜索

启发策略:

- 估计一个状态到目标距离的函数

- 问题给予算法的额外信息,为特定搜索问题而设计

启发式函数:

h(n)=节点n到目标节点的最小代价路径的代价估计值

启发式搜索:

采用了启发式函数的搜索策略

- 贪婪搜索

- 扩展距离目标最近的结点

- 启发式:对每个状态估计到最近目标的距离(h(n))

- A*搜索

- 启发式:同时结合了g(n)(到达此结点已经花费的代价)和h(n)

局部搜索

不关心路径,从单个当前结点出发,通常只移动到他的邻近状态,一般情况下不保留搜索路径

有两个优点:

- 通常只用常数级内存

- 通常能在系统化算法不适用的很大或无限的状态空间中找到合理的解

如果存在解,最优的局部搜索算法总能找到全局最大/最小值

- 爬山法搜索

- 模拟退火搜索

- 遗传算法

深度学习

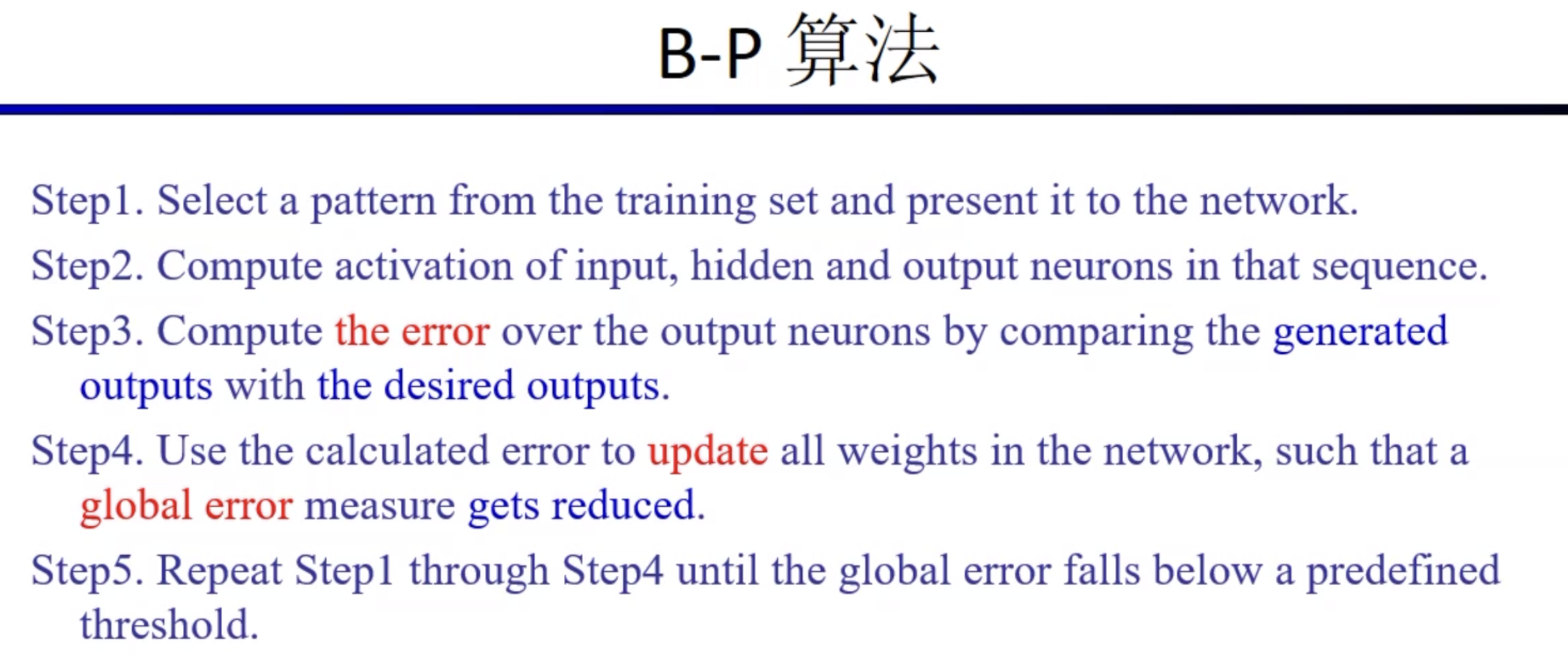

人工神经网络和深度学习基础

- 人工神经网络部分–多层感知机,BP算法

- 深度学习

- 深度神经网络

- 自编码器

- 栈式自编码器

- 深度置信网络(DBN)

- 深度玻尔兹曼机(DBM)

卷积神经网络

- dropout

- 局部对比归一

- Inception

- Post title:deeplearning

- Post author:calcium_oxide

- Create time:2022-09-02 10:22:25

- Post link:https://yhg1010.github.io/2022/09/02/deeplearning/

- Copyright Notice:All articles in this blog are licensed under BY-NC-SA unless stating additionally.